Překvapení: Facebook říká, že Facebook je v pořádku pro novinky!

Jediný problém? Jedná se o studii na Facebooku provedenou lidmi, kteří jsou zaměstnáni na Facebooku.

Měli bychom být opravdu tak překvapeni, že vlastní výzkumní pracovníci Facebooku minimalizují dopad manipulace jejich společnosti se zpravodajskými informacemi lidí?

Studium, Vystavení ideologicky různorodým zprávám a názorům na Facebooku, Eytana Bakshyho a kolegů z Facebooku, byl zveřejněn minulý týden v Věda. Jak mohla být tato studie zveřejněna v prestižním časopise Věda? 1 Nemělo by vzájemné hodnocení zachytit samoúčelné studie publikované společnostmi, které ukazují pouze to, co chce společnost ukázat?

Je třeba si klást otázku, jak recenzenti tuto studii zveřejnili. Mnoho kritik této studie již bylo publikováno, takže udělám jen rychlý přehled problémů citovaných ostatními. Tato kritika od Christiana Sandviga do značné míry shrnuje problém s tím, jak vědci Facebooku v publikované studii točili svá vlastní zjištění:

Pokud jde o srovnání, studie dále uvádí, že:

"Přesvědčivě stanovujeme, že ... individuální volby více než algoritmy omezují vystavení obsahu náročnému na přístup."

„Ve srovnání s algoritmickým hodnocením mělo rozhodování jednotlivců o tom, co konzumovat, silnější účinek“

Zvoní mi poplašné zvony. Tabákový průmysl mohl jednou financovat studii, která říká, že kouření je méně nebezpečné než těžba uhlí, ale zde máme studii o kouření těžařů uhlí. Pravděpodobně, když jsou v uhelném dole.

Chci tím říci, že neexistuje žádný scénář, ve kterém by bylo možné obchodovat s „uživatelskými volbami“ vs. „algoritmem“, protože k nim dochází společně […]. Uživatelé si vyberou z toho, co pro ně již algoritmus filtroval. Je to sekvence.

Myslím, že správné prohlášení o těchto dvou věcech je, že jsou špatné - obě zvyšují polarizaci a selektivitu. Jak jsem řekl výše, zdá se, že algoritmus mírně zvyšuje selektivitu uživatelů.

Ve skutečnosti byste si mysleli, že výzkumníci z Facebooku, kteří, jak víte, pracují na Facebooku, pochopí, že nemůžete dráždit a oddělit algoritmus od chování uživatele, protože jeden je závislý na druhém. Bez manipulace s algoritmem (což průzkum Facebooku, který Adam Kramer zjistil, není dobrá věc bez získání informovaného souhlasu uživatele), nemůžete skutečně říci, proč uživatelé klikají na jednu věc více než na něco jiného.

Ale tato recenze studie na Facebooku od Zeynep Tufekci, profesora na univerzitě v Severní Karolíně, Chapel Hill, napsala, že to, co data studie skutečně našla, byla zakopána v příloze studie:

Čím vyšší je odkaz, tím je pravděpodobnější, že na něj bude kliknuto. Žijete a umíráte umístěním, které určuje algoritmus novinek. (Efekt, jak správně poznamenává Sean J. Taylor, je kombinací umístění a skutečnosti, že algoritmus hádá, co byste chtěli).

Většinou to již bylo známo, ale je skvělé, že to potvrdili vědci Facebooku (studie byla autorem výhradně zaměstnanců Facebooku). […]

Jedním z nových zjištění je, že algoritmus informačního kanálu (mírně) potlačuje různorodý obsah, a dalším zásadním a také novým zjištěním je, že umístění ve zdroji je (silně) ovlivněno mírou prokliku.

Facebook vám zobrazuje novinky, které s větší pravděpodobností přečtete (protože souhlasí s vaším politickým pohledem) a že čím vyšší je ve vašem informačním kanálu, tím větší je pravděpodobnost, že na něj kliknete.

Jinými slovy, manipulace Facebooku s vašimi novinkami je i nadále důležitým faktorem, který přispívá k určení toho, na co pravděpodobně kliknete. A nadále manipulují s tímto zdrojem, aby vám zobrazovali politicky sladěné zprávy více, než kdyby v jejich algoritmu nebyla žádná předpojatost.

A jak Tufekci důležitě poznamenává, šlo o malou vybranou skupinu uživatelů Facebooku, která byla studována, jen proto, že pro výzkumníky Facebooku bylo pohodlnější (a levnější) je studovat. Dívali se pouze na uživatele, kteří sami identifikovali svou politickou příslušnost na Facebooku a pravidelně se přihlašují ke službě (přibližně 4 procenta z celkového počtu uživatelů Facebooku [pouze 9 procent uživatelů deklaruje svou politickou příslušnost na Facebooku), což znamená, že nejde o vzorek, který lze zobecnit cokoli od]). Neříká nic o uživatelích Facebooku, kteří na Facebooku nedeklarují svoji politickou příslušnost - což je většina z nás.

Mohl Facebook provést důkladnější studii? Jistě, ale vyžadovalo by to tradičnější výzkumné techniky, jako je nábor průzkumu na webu v kombinaci s náhodným náborem e-mailů mimo web.

Tady je tedy nefiltrované, nezaujaté zjištění z údajů (s laskavým svolením Tufekci), které se vědci Facebooku zdánlivě otočili a řekli, že to, co vidíte v jejich novinkách, není jejich chyba:

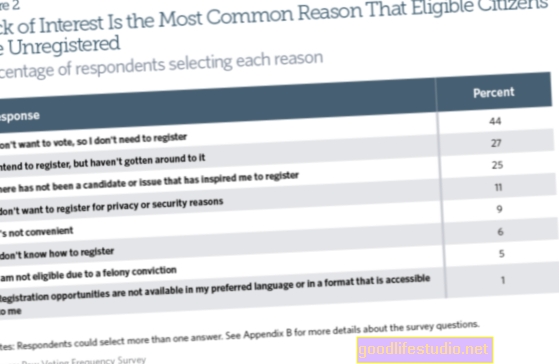

Výzkumníci Facebooku přesvědčivě ukazují, že algoritmus posílání novinek na Facebooku snižuje ideologicky různorodý a průřezový obsah, který lidé vidí ze svých sociálních sítí na Facebooku, měřitelně. Vědci uvádějí, že vystavení různorodému obsahu je potlačeno algoritmem Facebooku o 8% u sebeidentifikovaných liberálů a o 5% u sebeidentifikovaných konzervativců.

Nebo, jak uvádí Christian Sandvig, „algoritmus odfiltruje 1 z 20 průřezových tvrdých zpráv, které vidí konzervativní konzervativní člověk (nebo 5%), a 1 ze 13 průřezových tvrdých zpráv, které identifikuje liberální vidí (8%). “ Vidíte méně zpráv, se kterými nesouhlasíte a které sdílí vaši přátelé, protože vám je algoritmus nezobrazuje.

Bohužel mimo New York Times a několik vybraných dalších prodejen, většina mainstreamových webů se zpravodajskými médii právě bez skepticismu hlásila to, co výzkumníci Facebooku tvrdili ve své studii.

Ale teď víte pravdu - Facebook studoval malý, nereprezentativní vzorek, poté bagatelizoval, co jejich data ve skutečnosti ukázala, aby zdůraznil výsledek, který byl pro společnost pozitivnější. Pro mě je to další příklad výzkumníků Facebooku, kteří ve skutečnosti nerozumí smyslu vědeckého výzkumu - sdílet znalosti se světem, který není zaujatý a manipulovaný.

Pro další čtení…

Zeynep Tufekci: Jak algoritmus Facebooku potlačuje rozmanitost obsahu (mírně) a jak Newsfeed řídí vaše kliknutí

Christian Sandvig: Studie „Není to naše chyba“ na Facebooku

NY Times: Facebook používá polarizaci? Stránky se začínají lišit

Poznámky pod čarou:

- Je smutné, že nyní musím do svého seznamu respektovaných vědeckých publikací přidat další časopis, který je třeba dále zkoumat. Jak vědí dlouholetí čtenáři World of Psychology, tento seznam se každým rokem prodlužuje: Pediatrie (Pediatrics publikuje studie o technologii, které zjevně přezkoumává nikdo obeznámený s kauzálními vztahy základního výzkumu.), Cyberpsychologie, chování a sociální sítě (Cyberpsychology zjevně publikuje jakoukoli studii o závislosti na internetu nebo sociálních sítích, bez ohledu na její kvalitu.) A nyní, Věda. [↩]